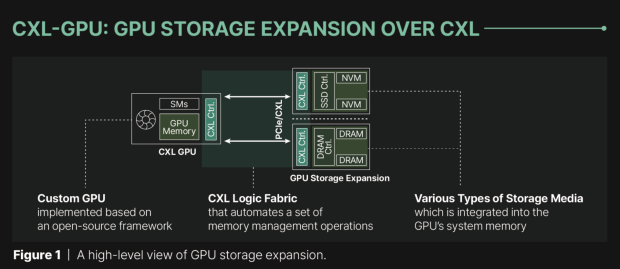

Panmnesia è un'azienda di cui probabilmente non avete mai sentito parlare fino a oggi, ma la startup KAIST ha svelato la sua IP all'avanguardia che consente di aggiungere memoria esterna alle GPU AI tramite il protocollo CXL su PCIe, il che consente nuovi livelli di capacità di memoria per i carichi di lavoro AI.

GUARDA LA GALLERIA – 3 IMMAGINI

Le flotte attuali di GPU AI e acceleratori AI utilizzano la loro memoria di bordo, solitamente HBM superveloce, ma questa è limitata a quantità più piccole come 80 GB sull'attuale GPU AI NVIDIA Hopper H100. Le offerte di chip AI di prossima generazione di AMD e NVIDIA introdurranno fino a 141 GB di HBM3E (GPU AI H200 di NVIDIA) e fino a 192 GB di HBM3E (GPU AI B200 di NVIDIA e Instinct MI300X di AMD).

Ma ora, il nuovo IP CXL di Panmnesia consentirà alle GPU di accedere alla memoria da DRAM e SSD, espandendo la capacità di memoria dalla sua memoria HBM integrata… molto carino. La startup del South Korean Institute (KAIST) collega la connettività con CXL tramite collegamenti PCIe, il che significa che l'adozione di massa è facile con questa nuova tecnologia. Gli acceleratori AI regolari non hanno i sottosistemi richiesti per connettersi e utilizzare CXL per l'espansione della memoria direttamente, basandosi su soluzioni come UVM (Unified Virtual Memory) che è più lenta, vanificando completamente lo scopo… ed è qui che entra in gioco il nuovo IP di Panmnesia.

Advertisement

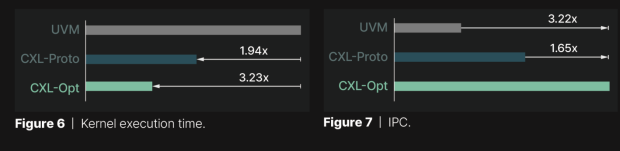

Panmnesia ha confrontato la propria soluzione “CXL-Opt” con i prototipi di Samsung e Meta, che hanno etichettato come “CXL-Proto”. CXL-Opt ha una latenza di andata e ritorno molto più bassa, ovvero il tempo impiegato dai dati per viaggiare dalla GPU alla memoria e poi tornare indietro. Il nuovo CXL-Pro di Panmnesia ha goduto di una latenza di nanosecondi a due cifre, rispetto ai 250 ns di latenza dei suoi concorrenti. Il tempo di esecuzione di CXL-Opt è anche molto inferiore a UVM, poiché raggiunge miglioramenti delle prestazioni IPC di 3,22 volte rispetto a UVM. Impressionante.

La nuova soluzione CXL-Pro di Panmnesia potrebbe fare grandi onde nel mercato delle GPU AI e degli acceleratori AI, fungendo da soluzione tra l'impilamento dei chip di memoria HBM e il passaggio a una soluzione molto più efficiente. Panmnesia è una delle prime con il suo nuovo IP CXL, quindi sarà interessante vedere come andremo avanti da qui.

Advertisement